Współczesna architektura korporacyjna przypomina misternie tkany gobelin, w którym nitki innowacji przeplatają się z surowym rygorem bezpieczeństwa. Przez dekady symbolem niekontrolowanego ryzyka pozostawało zjawisko Shadow IT – partyzantka technologiczna pracowników, którzy na własną rękę wdrażali nieautoryzowane oprogramowanie, by ułatwić sobie codzienną pracę. Jednak u progu 2026 roku definicja tego zagrożenia uległa drastycznej ewolucji. Dziś największe wyzwanie nie wiąże się z aplikacjami instalowanymi potajemnie, ale z tymi, które już posiadają status zaufanych. To cicha rewolucja zintegrowanej, niezarządzanej sztucznej inteligencji, która staje się nowoczesnym koniem trojańskim, wprowadzonym do organizacji nie przez błąd, ale w ramach oficjalnej aktualizacji.

Pułapka domyślnej efektywności

Fenomen, przed którym ostrzegają najnowsze raporty bezpieczeństwa, w tym analizy ThreatLabz, opiera się na paradoksie zaufania. Większość organizacji operuje w paradygmacie, w którym zweryfikowane narzędzia typu SaaS są uznawane za bezpieczne bastiony. Tymczasem masowa implementacja funkcji generatywnych wewnątrz edytorów tekstu, arkuszy kalkulacyjnych czy platform komunikacyjnych odbywa się często w sposób niemal niezauważalny. Funkcje te, aktywne domyślnie, omijają tradycyjne filtry bezpieczeństwa zaprojektowane do wykrywania klasycznych zagrożeń.

W efekcie granica między intencjonalnym działaniem człowieka a autonomiczną aktywnością botów ulega niebezpiecznemu rozmyciu. Pracownik, szukając optymalizacji czasu pracy, nieświadomie staje się ogniwem w łańcuchu transferu danych, którego skala przekracza najśmielsze prognozy. Skalę tego zjawiska obrazuje dynamika przepływu informacji do zewnętrznych modeli uczenia maszynowego, która osiągnęła poziom osiemnastu tysięcy terabajtów rocznie. To masowa migracja kapitału intelektualnego firm do zewnętrznych, często niekontrolowanych repozytoriów.

Architektura wycieku pod przykryciem innowacji

Problem niezarządzanej sztucznej inteligencji dotyka fundamentów suwerenności danych. Narzędzia wspierające poprawność językową czy asystenci kodowania przekształciły się w jedne z najpotężniejszych centrów wywiadu korporacyjnego na świecie. Każdy poprawiony dokument, każda zoptymalizowana linia kodu źródłowego czy podsumowane spotkanie zarządu staje się elementem wielkiego zbioru uczącego, nad którym organizacja traci jurysdykcję w momencie kliknięcia przycisku „generuj”.

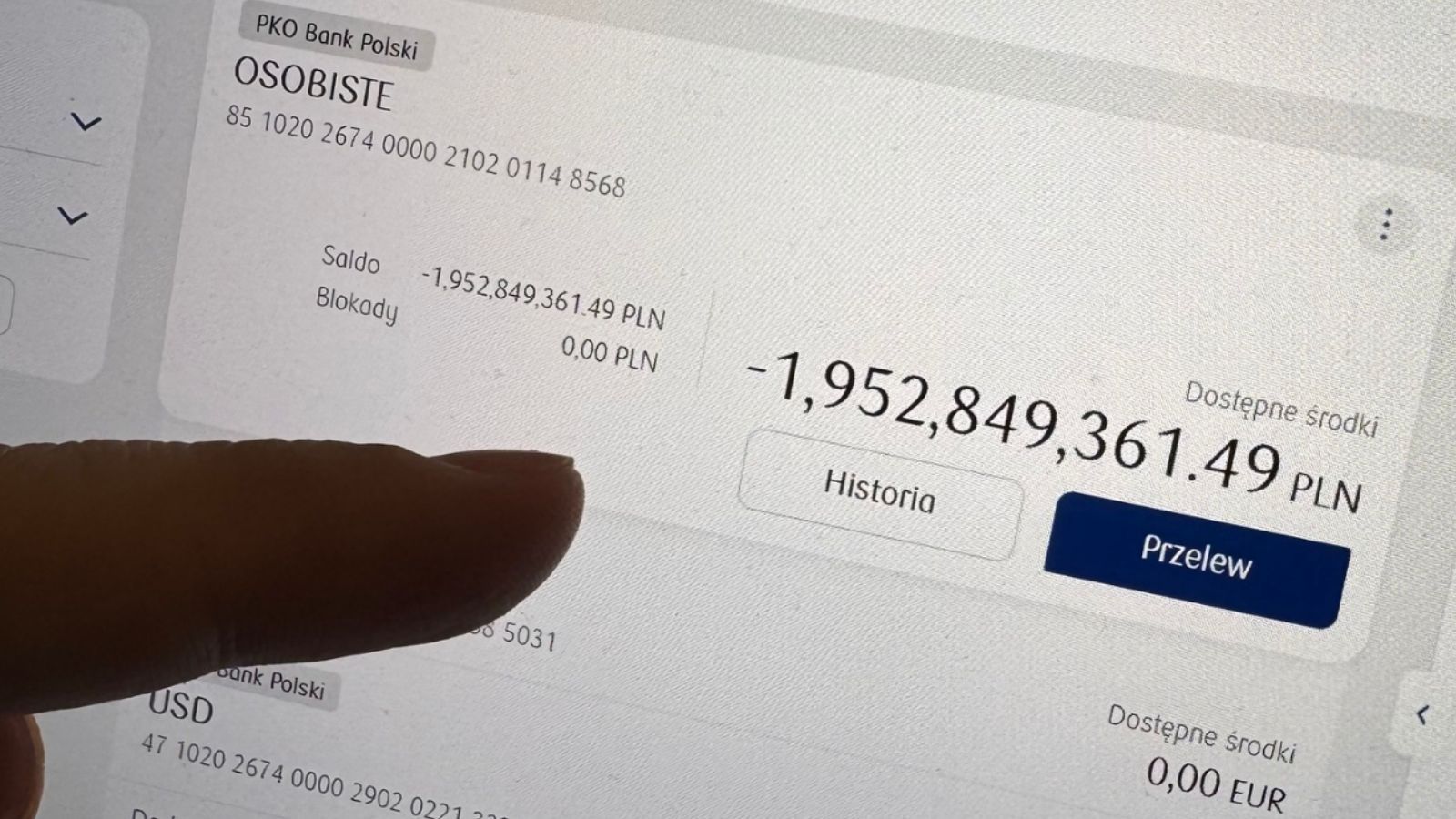

Analiza incydentów pokazuje, iż mechanizmy zapobiegania utracie danych (DLP) rejestrują setki milionów naruszeń związanych z udostępnianiem informacji wrażliwych. Wśród nich znajdują się dane tak krytyczne jak numery ubezpieczeń społecznych, dokumentacja medyczna czy strategiczne plany rozwoju. Niepokojący jest fakt, iż proces ten odbywa się w atmosferze entuzjazmu dla wzrostu produktywności, co usypia czujność osób odpowiedzialnych za zarządzanie ryzykiem. Brak rzetelnej inwentaryzacji aktywnych modeli AI sprawia, iż większość liderów biznesowych operuje w próżni informacyjnej, nie mając jasnej mapy punktów styku własnych danych z zewnętrznymi algorytmami.

Słabość łańcucha dostaw w dobie autonomii

Ewolucja zagrożeń nie zatrzymuje się na poziomie interfejsu użytkownika. Strategiczne ryzyko przenosi się głębiej, w sferę łańcucha dostaw sztucznej inteligencji. Szybka adopcja modeli wymusiła na działach IT korzystanie z gotowych bibliotek i plików modeli, które często stają się celem precyzyjnych ataków. Słabości w popularnych komponentach AI pozwalają napastnikom na uzyskanie bocznego dostępu do rdzennych systemów biznesowych, co przy wykorzystaniu autonomicznych systemów ataku czyni tradycyjną obronę przestarzałą.

Warto zaznaczyć, iż ludzka zdolność reakcji staje się wąskim gardłem. Testy wydolnościowe systemów obronnych w warunkach rzeczywistych wykazują, iż czas do pierwszej krytycznej awarii mierzy się w minutach. Skuteczność ataku napędzanego przez AI polega na jego umiejętności błyskawicznej adaptacji i rozpoznania struktury sieci, co czyni statyczne zapory ogniowe jedynie kosztownym reliktem przeszłości. Organizacje, które nie uwzględniają w swoich strategiach bezpieczeństwa faktu, iż ich przeciwnikiem może być algorytm działający bez przerwy i z prędkością procesora, mogą pozostać bezbronne mimo posiadania teoretycznie solidnych zabezpieczeń.

Od reaktywności do inteligentnego nadzoru

Rozwiązanie problemu nowoczesnego Shadow IT nie leży w powrocie do polityki restrykcyjnych zakazów. Historia technologii uczy, iż próby blokowania narzędzi zwiększających efektywność kończą się jedynie głębszym zejściem do podziemia technologicznego. Kluczowym wyzwaniem dla kadry zarządzającej jest transformacja modelu nadzoru z reaktywnego na proaktywny. Oznacza to konieczność wdrożenia inteligentnych architektur typu Zero Trust, które są w stanie analizować kontekst i intencję każdego transferu danych w czasie rzeczywistym.

Fundamentalnym elementem nowej strategii jest koncepcja defensywnej sztucznej inteligencji. Skoro ataki są zautomatyzowane i skalowalne, systemy obronne muszą posiadać analogiczną autonomię. Agenci AI dedykowani bezpieczeństwu potrafią obserwować anomalie w zachowaniu aplikacji SaaS, identyfikować nieautoryzowane próby eksportu danych i podejmować natychmiastowe środki zaradcze, zanim incydent przerodzi się w kryzys wizerunkowy lub finansowy.

Strategiczne priorytety

Refleksja nad obecnym stanem cyberbezpieczeństwa prowadzi do wniosku, iż najwyższa pora na rzetelny audyt zasobów cyfrowych pod kątem ich „inteligencji”. Pierwszym krokiem do odzyskania kontroli jest stworzenie transparentnej inwentaryzacji wszystkich punktów styku, w których dane firmowe karmią zewnętrzne algorytmy. Wymaga to bliskiej współpracy międzyresortowej, ponieważ ryzyko AI dotyka zarówno działów prawnych (zgodność i compliance), jak i operacyjnych czy HR.

Gdy przewaga konkurencyjna budowana jest na unikalności posiadanych informacji, ich bezrefleksyjne rozproszenie w chmurach obliczeniowych dostawców AI jest luksusem, na który żadne przedsiębiorstwo nie może sobie pozwolić. Edukacja kadr, choć kluczowa, musi zostać wsparta przez technologiczne bariery, które rozumieją specyfikę języka naturalnego i potrafią odróżnić bezpieczne zapytanie od próby eksportu kodu źródłowego.

Zatem zintegrowana sztuczna inteligencja jako nowy wymiar Shadow IT wymaga od liderów biznesu odwagi w przyznaniu, iż dotychczasowe metody kontroli są niewystarczające. Przyszłość należy do organizacji, które potrafią wyważyć entuzjazm dla innowacji z chłodną analizą ryzyka, wdrażając systemy zdolne do walki z zagrożeniami o prędkości maszyny. To kwestia umiejętności harmonijnego połączenia obu tych wartości w świecie, w którym algorytm stał się zarówno najpotężniejszym pracownikiem, jak i najbardziej nieuchwytnym włamywaczem. Warto zatem rozważyć przeprowadzenie wewnątrz organizacji kompleksowej analizy ekspozycji danych w najczęściej używanych aplikacjach typu SaaS, co pozwoli na realną ocenę skali zjawiska niezarządzanej sztucznej inteligencji w strukturach firmy.

3 godzin temu

3 godzin temu